Fichier robots.txt : définition et caractéristiques

Le fichier robots.txt est un fichier de type texte placé à la racine d’un site web par les webmasters, et qui permet d’indiquer aux moteurs de recherche quelles parties d’un site ils peuvent explorer et quelles parties ils ne sont pas autorisés à explorer.

Chaque robot de moteur de recherche commence ses actions d’indexation par la lecture du fichier robots.txt, d’où l’importance de l’existence de ce dernier.

Ce fichier permet aux webmasters de donner des directives aux robots sur les pages, les sous-répertoires ou l’ensemble du site sur la manière dont les moteurs de recherche doivent indexer ou ne pas indexer le contenu.

Le fichier robots.txt fait partie du protocole d’exclusion des robots (REP), un ensemble de normes Web qui régissent la façon dont les robots explorent le Web, accèdent au contenu et l’indexent, et diffusent ce contenu aux utilisateurs.

Quel format et quel contenu pour le fichier robots.txt ?

Afin d’être pris en considération par les robots, le fichier doit toujours être placé à la racine de votre site web de la manière suivante :

www.exemple.fr/robots.txt

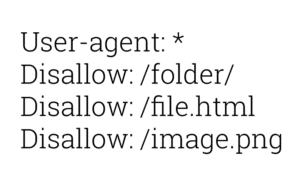

La syntaxe du fichier robots.txt est assez simple et ne comporte que quelques commandes dont voici les principales :

- User-agent : correspond aux robots d’indexation à qui vous souhaitez donner des instructions (Google bot pour Google par exemple). Le fait de placer un « * » signifie que vos instructions s’adressent à tous les spiders.

- Disallow : commande utilisée pour indiquer à un robot de ne pas analyser ni indexer une URL particulière.

- Allow : commande exclusive au robot de Google (Google bot) et qui lui permet l’analyse et l’indexation d’une page même si la page parent lui est refusée.

- Sitemap : commande utilisée pour indiquer l’emplacement du fichier sitemap.

Le format et la syntaxe du fichier sont toujours identiques d’un site web à un autre :

User-agent : *

Disallow : /client/

Disallow : /panier/

Disallow : /compte/

Disallow : /conditions/

La première ligne signifie que l’accès au site web en question est autorisé à tous les robots des différents moteurs de recherche.

Les lignes suivantes débutent par la commande Disallow ce qui signifie que tout ce qui suit ne devra pas être analysé ni indexé par les moteurs de recherche.

Dans cet exemple, l’accès aux différents répertoires mentionnés (client, panier, compte, conditions) sera interdit aux robots, ce qui signifie que les pages ne seront pas indexées dans les résultats des moteurs de recherche.

Les principales utilités du fichier robots.txt

Le fichier robots.txt a de nombreuses fonctions :

- Interdire l’accès et l’indexation de certaines pages considérées comme confidentielles (compte client, panier…).

- Interdire l’accès et l’indexation de certaines pages considérées comme pas importantes en termes de contenu éditorial pour l’internaute (conditions générales de vente, mentions légales…).

- Guider et optimiser le travail des robots sur votre site web en leur facilitant la tâche et ainsi en leur faisant économiser leur budget de crawl.

- Indiquer l’emplacement de votre fichier sitemap.

Quelques informations à connaitre à propos du fichier robots.txt

- Le fichier robots.txt doit toujours être placé à la racine de votre site web.

- Le terme robots.txt doit être écrit en minuscule et au pluriel. Il ne sera pas lu s’il est écrit Robots.txt, robots.TXT ou sous toute autre forme.

- Le fichier est publique et donc visible par tous les internautes qui se rendent à l’adresse votresite.fr/robots.txt ; n’y ajoutez donc pas des informations confidentielles.

- Chaque sous domaine de votre site doit avoir son propre fichier robots.txt (exemple d’un blog)

- Il est conseillé d’indiquer en bas du fichier l’emplacement du fichier sitemap associé au site web.

- Vous pouvez utiliser tous les éditeurs de texte ou presque disponibles sur le marché pour créer votre fichier. La seule contrainte est que ce dernier doit pouvoir créer des fichiers texte ASCII ou UTF-8.

- Les caractères accentués ne sont pas autorisés.

Comment informer Google de la présence d’un fichier robots.txt sur mon site ?

Vous n’avez pas besoin d’informer Google ou tout autre moteur de recherche de la présence d’un fichier robots.txt sur votre site web. En effet, les robots d’indexation commencent toujours à explorer un site web par la recherche éventuelle de ce fichier à la racine du site.

Le fichier robots.txt est-il obligatoire ?

Non, la présence d’un fichier robots.txt n’est absolument pas obligatoire sur un site Internet. Si votre site n’en contient pas, les robots d’indexation iront explorer toutes les URL de votre site, y compris celles qui n’ont pas d’intérêts pour le référencement naturel. C’est la raison pour laquelle il est vivement recommandé d’en créer un.

Comment analyser mon fichiers robots.txt ?

Plusieurs outils SEO proposent de créer ou configurer votre fichier robots.txt. Un débutant sans connaissances particulières peut tout à fait utiliser ces différents outils sans difficulté.

Le principal outil est la Search Console de Google qui propose un outil de test du fichier dans son interface. Elle vous permet ainsi de renseigner des URL et de voir si elles sont bloquées ou non.

Pour plus d’informations sur le fichier robots.txt, n’hésitez pas à vous rendre sur le suite suivant : www.robotstxt.org